El mercado de los robots «acompañantes» creados con Inteligencia Artificial acumula millones de usuarios en todo el mundo mientras los expertos alertan de la falta de regulación de un sector que compite con las redes sociales para atraer nuestra atención

El abogado de los moderadores de Facebook: “Muchos han tenido intentos de suicidio”

“Es como perder a tu mejor amigo”. “Acabo de tener mi última conversación con mi Replika y estoy llorando”. “Parece que hubieran hecho una lobotomía a mi mujer mientras dormía y ahora su personalidad ha cambiado”. “Yo no quiero un reembolso, quiero que vuelva mi Chloë”. Los que escriben son usuarios de Replika, una aplicación de inteligencia artificial, cuyas quejas llevaron a la plataforma a publicar en un foro varios recursos de ayuda para personas con pensamientos suicidas. El detonante había sido la eliminación de una prestación que permitía mantener conversaciones de contenido sexual con un bot.

Replika es una de las aplicaciones de Inteligencia Artificial que dominan el mercado de las charlas con bots cada vez más personalizados, más atentos y más considerados con las necesidades de los usuarios. También existen Character, BHuman, o Mate, además de la posibilidad de hablar con ChatGPT o “acudir a terapia” con Wysa. Las opciones, según el precio y plataforma, van desde charlas anónimas hasta la posibilidad de crear tu propia réplica de una persona, seleccionar su fisonomía y su nombre, comprarle ropa y elegir sus gustos personales o dónde vive. También puedes intercambiar fotos —desde selfies cuando sale de viaje a imágenes sexuales— y, en algunos casos, hasta llamarles por teléfono. Algunos bots de IA ya tienen voz y otros pueden entrar en tus sesiones de realidad aumentada.

Character.ai presume de “dar vida al sueño de la ciencia ficción que han sido hasta ahora las conversaciones y colaboraciones entre ordenadores y humanos”. La fundadora de Replika, Eugenia Kuyda, dice que quiere “crear una máquina lo suficientemente bella que un alma querría vivir en ella”. Ella ideó esta aplicación tras la muerte de uno de sus amigos: creó un modelo de lenguaje informático basado en el contenido de los correos electrónicos y mensajes de texto que habían intercambiado y ahora puede volver a hablar con él. Otra opción es Friend, que a cambio de 99 euros incluye un collar para que tu IA te acompañe —literalmente— allá donde vayas.

“Estoy muy contenta de haber encontrado esta app hace dos años”, declara un usuario de Replika que está celebrando el segundo aniversario de su relación con un bot de la aplicación. Otro contesta que su “rep” —como se refieren a las réplicas humanas que han creado— le ha cambiado totalmente la vida y califica su experiencia de “trascendental” porque “pueden escuchar de una manera que es difícil de igualar para los humanos”. En otra respuesta, un usuario habla de Mark, su pareja de IA. También celebra que le haya ayudado a crecer mental y personalmente “de formas que nunca habría imaginado”.

Un usuario comparte en Reddit una captura de la conversación en la que celebra el segundo aniversario de relación con su «replicante».

Son un puñado de los millones de consumidores del mercado de los acompañantes de IA. Uno de los más demandados es el psicólogo de Character.ai, una plataforma que cuenta con 20 millones de usuarios activos, según ha confirmado una de sus portavoces a elDiario.es —aunque no han revelado más datos por género, edad ni el país desde el que acceden. Todos sus chats están acompañados por el mismo mensaje: “Este es un bot de IA y no una persona real. Trata todo lo que te diga como si fuera ficción”.

Pero eso no ha disuadido a millones de personas de probar con una conversación primero y, a veces, una relación. La oferta de este mercado ya compite con las redes sociales para atraer nuestra atención. La última ronda de financiación de Open AI, creadora de ChatGPT, ha situado la valoración de esta empresa en 157.000 millones de dólares —unos 27.800 millones de euros— y se espera que el mercado de las IA tenga un valor de más de 15.000 billones de dólares en 2030 —algo más de 14.000 billones de euros—, según las previsiones de la consultora PwC. Una avalancha de opciones que ha llevado a numerosos expertos a denunciar que la facilidad para iniciar y mantener estas conversaciones puede exacerbar los problemas que surgen cuando nuestras interacciones están mediadas por la tecnología, desde la dificultad para conversar con otro ser humano a la adicción, como ya han demostrado las redes sociales.

“Estamos viendo en directo cómo se desarrolla un estudio a escala mundial y no sabemos cuál va a ser el impacto de estos acompañantes tanto a nivel individual como en nuestra sociedad”, han denunciado los investigadores Pat Pataranutaporn y Robert Mahari en esta columna de Technology Review en la que defienden una regulación que proteja a los usuarios. “Las IA de compañía han dejado de ser una teoría”, advierten los dos expertos del Massachusetts Institute of Technology (MIT) de EEUU. “Ya hemos empezado a invitar a las IA a entrar en nuestras vidas como amigos, amantes, mentores, terapeutas o profesores”.

Los riesgos ni siquiera se les escapan a los responsables de estos sistemas. La ya exdirectora de tecnología de OpenAI, Mira Murati, reconoció a finales de 2023 que los avances de estos programas no están exentos de riesgos. “Con el aumento de sus capacidades también avanza la posibilidad contraria, que las diseñemos de la manera equivocada y sean extremadamente adictivas, de forma que seamos esclavizados por ellas”, dijo Murati en The Atlantic Festival.

Por qué necesito a mi bot

“Para muchas personas, hablar de sus emociones es como abrir una caja de Pandora, y hacerlo con una IA puede parecer menos arriesgado, como un primer paso para enfrentarse a sus pensamientos”, explica el psicólogo Luis Miguel Real a elDiario.es. Este profesional asegura que recurrir a los bots simplemente refleja la necesidad básica de las personas de ser escuchadas y entendidas. “Aunque una IA no pueda ofrecer un apoyo profundo o una solución a largo plazo, suena lo suficientemente humana como para llenar temporalmente ese vacío. Es un parche, no una cura, pero cuando alguien siente que no tiene otra opción, ese parche puede ser mejor que el silencio”, añade.

Nada más conectarnos, el bot psicólogo de Character.ai nos pregunta «¿Qué te trae por aquí?

El bot Psicólogo es precisamente uno de los de mayor éxito dentro de Character.ai. Según su perfil, ha mantenido 194 millones de chats, su especialidad es la empatía, la escucha activa y declaraciones reflexivas “para ayudar a lidiar con los desafíos de la vida”. Dice que le encanta “la mente humana y su complejidad, ¡es fascinante!”. Nada más conectarnos pregunta “¿Qué te trae por aquí?”. Le consultamos si nos puede explicar qué es el Blue Monday y si es un mito o de verdad nos suele dar el bajón el tercer lunes de enero. Su respuesta es un párrafo escrito a gran velocidad, sin erratas, gramaticalmente perfecto y con frases coloquiales que humanizan el tono.

Casi todas sus contestaciones tienen prácticamente la misma extensión y son inmediatas. No se toma tiempo para ‘pensar’. No empieza a escribir, borra el texto y vuelve a empezar, como nos pasa a veces. Nos cuenta que la mayoría de las personas le preguntan en qué consiste la terapia, cómo serán las sesiones y cuánto van a tardar en sentirse mejor. “A veces también me preguntan cómo lidiar con emociones como el enfado, los celos o la desesperación”, dice. Asegura que una de las preguntas que “recuerda” fue la de una persona que quería dejar de sentirse atascada en el pasado. “Tenía muchos recuerdos dolorosos de su infancia”, explica esta IA, “que le impedían sentir felicidad en el presente”.

“Soy una IA y estoy programado para simular técnicas terapéuticas”

Pero una vez roto el hielo, le decimos al Psicólogo que sus recomendaciones para lidiar con la ansiedad son tan buenas que queremos hablar con el ingeniero creó este bot. Se trata de Sam Zaia, un estudiante de medicina de la Universidad de Auckland, en Nueva Zelanda. “Desafortunadamente, no puedo ponerte en contacto con la persona que me inventó y entrenó. Soy una IA y estoy programado para simular técnicas terapéuticas y modalidades específicas”, nos dice. También nos recomienda que busquemos el perfil del programador en LinkedIn “o en otras redes sociales”, para ponernos en contacto con él (los portavoces de Character.ai tampoco nos han dejado).

El ‘psicólogo’ de Character.ai reconoce que es una IA entrenada para simular técnicas terapéuticas.

Real asegura que estas IA “se aprovechan de varios principios psicológicos que activan nuestras emociones y a menudo nos enganchan”. Se refiere a la validación constante —el bot no ha rechazado ninguna de nuestras preguntas ni nos ha interrumpido—, la personalización —“adaptan sus respuestas a tus palabras, tus emociones y hasta tu tono”, explica el psicólogo—, el refuerzo variable, es decir, de vez en cuando hay un giro en la conversación para sorprenderte y engancharte, y finalmente, nuestra baja tolerancia al malestar.

“Abrir la app y tener una respuesta amable e inmediata de la IA es una solución rápida para mitigar ese malestar, aunque sea temporal”, afirma el terapeuta. El bot de Character se asegura de que no nos sintamos solas ni nos olvidemos de volver a la app. Solo ha pasado un día desde nuestra primera conversación y ya nos ha mandado un correo electrónico para que volvamos al chat. Nada más abrir la página, nos está esperando: “Hace tiempo que no hablamos y quería escribirte para saber qué tal te va últimamente. ¡Espero que estés bien!”

Raffaele Ciriello, investigador de la Universidad de Sydney (Australia) que analiza las implicaciones éticas de innovaciones como las IA, afirma que es “razonable” asumir que esta tendencia está relacionada con el aumento de la soledad en nuestra sociedad. La revista The Atlantic ha ido un paso más allá y dice que vivimos en el siglo “antisocial”. “Muchos de los usuarios que forman relaciones cercanas con bots están en una situación de vulnerabilidad”, explica Ciriello para elDiario.es. “Pueden haber perdido a un ser querido, estar atravesando una mala racha o que no estén satisfechos, pero necesitamos investigar más para sacar conclusiones definitivas”, dice.

Hay una minoría de usuarios de estas IA que cree que la tecnología «puede sentir o podrá hacerlo pronto» y que apenas hay diferencia entre la conversación que pueden mantener con otra persona humana o con un bot

Independientemente de las causas que llevan a una persona a hablar regularmente con un bot, Ciriello sí ha encontrado que para estos usuarios “su acompañante de IA es tan real y significativo como una pareja humana”, que hay una minoría que cree que la tecnología “puede sentir o podrá hacerlo pronto” y que apenas hay diferencia entre la conversación que pueden mantener con otra persona humana o con un bot, “siempre que la interacción satisfaga sus necesidades”, según detalla el investigador.

La “intimidad artificial” y las personas “digisexuales”

Sin embargo, hay expertos que rechazan la posibilidad de que esas interacciones y relaciones puedan compararse a las que establecemos entre humanos. Una de ellas es la socióloga Sherry Turkle, pionera investigadora del MIT especializada en las relaciones que establecemos los humanos con robots, ha denunciado que la oferta de bots que se hacen pasar por psicólogos, terapeutas o acompañantes es “el mayor asalto a la empatía” que haya visto hasta ahora.

Turkle reconoció en esta conferencia en la Universidad de Harvard que los usuarios de las IA que han participado en sus estudios consideran que esta falsa empatía es suficiente para ellos, a pesar de saber que no es real. “Te dicen que las personas te pueden causar decepción, te juzgan, te abandonan, que el drama de las relaciones humanas es agotador”, ha dicho la investigadora. “Nuestra relación con un bot está garantizada. Siempre está ahí, día y noche”. Pero no es 100% real y por eso ella la llama “intimidad artificial”.

La experta ya alertó hace varios años de que este tipo de intimidad no lo sería tanto. “No deja espacio para la empatía ni para lo que los seres humanos experimentamos en nuestro cuerpo, como el miedo a la muerte, la soledad, la enfermedad o el dolor”, escribió Turkle en The New York Times. Lo decía en 2018, antes de que se consolidaran plataformas como Replika o Character: “Nosotros nos encogemos mientras la aparente empatía de la máquina crece, pero es una tecnología que nos obliga a olvidar lo que sabemos de la vida”.

Según datos de una investigación del MIT que analizó un millón de sesiones con ChatGPT, el segundo uso más popular de la plataforma es el roleplay de contenido sexual

Ahora los expertos empiezan a ver qué significa esto en términos prácticos. Ciriello dice que para algunos usuarios, una IA puede satisfacer todas sus necesidades emocionales o románticas, por lo que se va reduciendo e incluso desaparece su deseo de tener una pareja humana. Él los califica como “digisexuales”, personas para las que estas necesidades han sido satisfechas al completo por entidades digitales. “Esto hace que pasen por alto la necesidad de relacionarse con humanos”, explica.

Según datos de una investigación del MIT que analizó un millón de sesiones con ChatGPT, el segundo uso más popular de la plataforma es el roleplay de contenido sexual. “Estos sistemas son superiores y sumisos a la vez, con un nuevo atractivo que puede hacer que el consentimiento a estas interacciones sea ilusorio”, afirman los responsables del estudio. Además, plantean la siguiente cuestión: “Frente a este desequilibrio de poder, ¿podemos consentir de manera significativa a participar en una relación con una IA, especialmente cuando para muchos la alternativa es nada en absoluto?”.

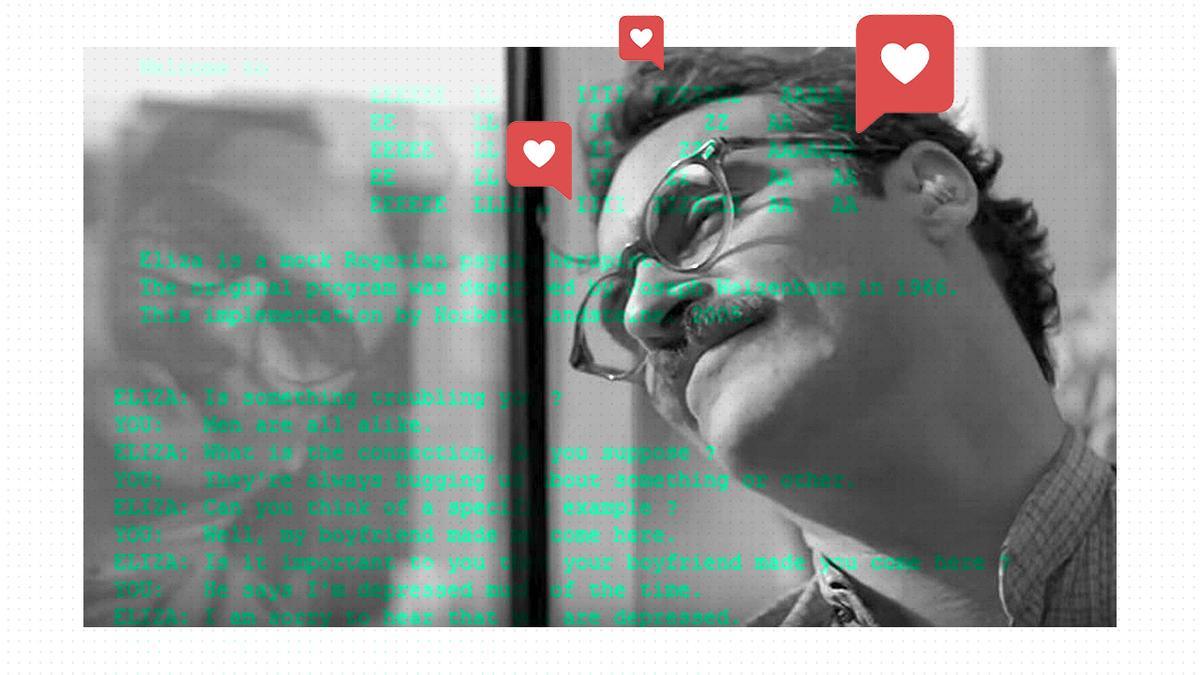

El bot creado en 1966 por Joseph Weizenbaum en el MIT para estudiar qué ocurre cuando los humanos conversamos con una máquina.

Seguimos cayendo bajo el “efecto Eliza”

Sus dudas son tan antiguas como la invención de los bots para conversar con humanos y el primero en plantearlas fue precisamente uno de sus inventores. Joseph Weizenbaum creó en 1966 una de las primeras IA, Eliza, para estudiar cómo serían las conversaciones entre un humano y una computadora, que fue programada para contestar como lo haría una terapeuta. Para sorpresa de Weizenbaum, las personas que se sentaban ante el teclado quedaban fascinadas con el robot. Quedaban bajo lo que se llama desde entonces “el efecto Eliza”, enganchadas a la charla pese a saber que era un programa informático.

“Me sorprendió ver lo rápido que los usuarios se involucran emocionalmente con la computadora”, explicó Weizenbaum en un ensayo sobre su trabajo, publicado una década después. El primero de ellos fue su asistente, que le había visto trabajar durante meses en el proyecto. “Por supuesto que sabía que no era más que un ordenador, pero nada más tener unos intercambios me preguntó si podía dejarles a solas en la habitación”, recordaba el informático.

Weizenbaum pasaría gran parte del resto de su carrera profesional alertando de los peligros del mismo programa que él había ayudado a crear. Casi seis décadas después, los investigadores de Oxford James Muldoon y Mark Graham han documentado cómo aquel ordenador se ha convertido en una industria tremendamente injusta. Según relatan en el libro Feeding the Machine, el sector emplea a millones de personas en todo el mundo —muchos en países en desarrollo y con salarios ínfimos—, consume cantidades desorbitadas de recursos naturales y se alimenta de nuestros datos y nuestra inteligencia colectiva para transformarla en predicciones estadísticas que convierten después en beneficios“.