Tendemos a pensar en las búsquedas en internet y en los sistemas de acceso a la información como desafíos eminentemente tecnológicos pero son también cuestiones filológicas de primer orden

El día que descubrí que los jóvenes utilizaban Tiktok como buscador para consultar información en internet entendí que me había hecho vieja definitivamente. Décadas de esfuerzo colectivo poniendo todo el conocimiento humano disponible en la web para que, entre otras cosas, fuera indexable y recuperable por los buscadores (y por lo tanto encontrable para los humanos) se daban de bruces con una brecha generacional insalvable. Pero estamos en 2024: las consultas, sospecho, ya no se hacen en Tiktok, sino que se le hacen directamente a chatGPT.

Y en realidad, lo entiendo. El internet que conocimos como archivo general del conocimiento humano hace tiempo que ya no existe. O, por lo menos, está en horas muy bajas. Las triquiñuelas de las páginas web para colocarse en los primeros puestos de los resultados de búsqueda y el cambio mental desde un internet basado en la idea del conocimiento abierto a uno de consumo infinito y muros de pago han dado sus frutos: el buscador da por hecho que el cibernauta (qué término tan demodé) ya no es alguien que acude a internet buscando información, sino alguien que va a comprar algo. La consecuencia es que el resultado de buscar en Google prácticamente cualquier cosa ya no es un listado de fuentes con información relevante que consultar, sino un catálogo de compra. Si una información existe pero el sistema de búsqueda no la puede recuperar (o aparece sepultada en la enésima página de resultados) es como si no existiera.

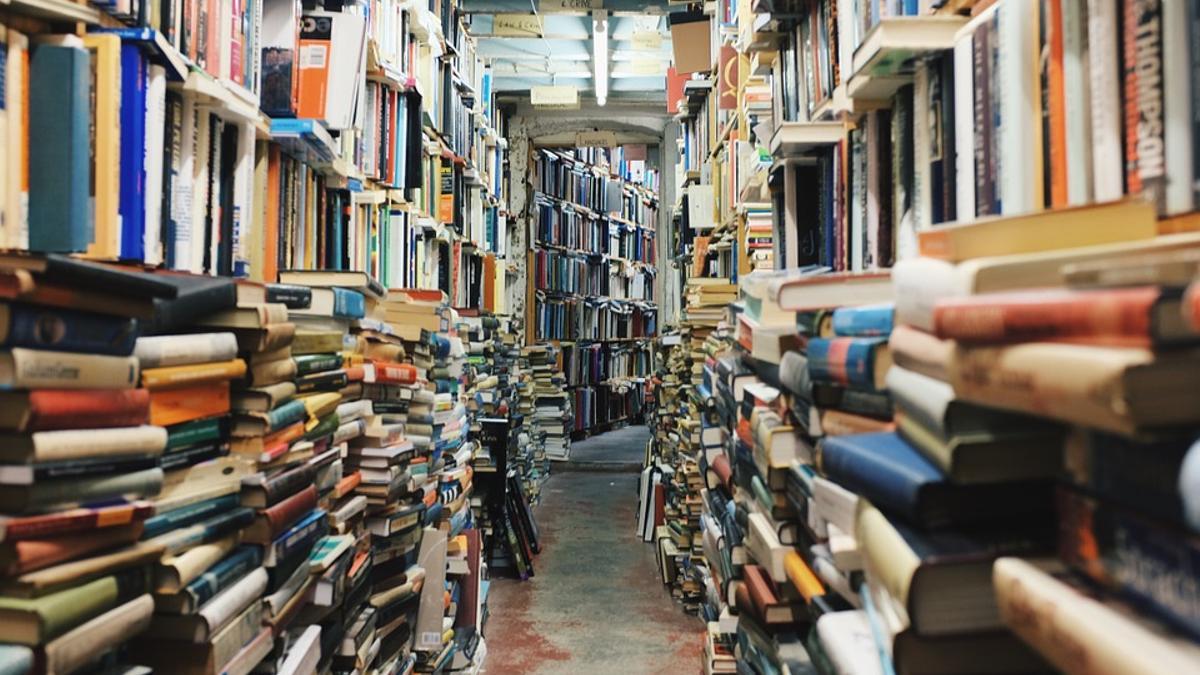

Con este panorama, es más que comprensible la preferencia por consultar chatGPT en vez de navegar por las páginas de resultados de un buscador roto. Si los buscadores convencionales funcionaban como bibliotecarios que señalaban al lector las baldas de la biblioteca relevantes para resolver su consulta (los enlaces), los grandes modelos de lenguaje como chatGPT ofrecen la promesa de ser sabios: chatGPT no te dice dónde debes mirar para encontrar información que responda a tu pregunta, sino que te da directamente una respuesta.

Y la idea sería estupenda, de no ser porque en realidad estos sabios saben poco. O por lo menos, han adquirido su conocimiento de maneras cuestionables. En último término, lo que estas insaciables criaturas computacionales han hecho es beberse todo el texto contenido en internet y aprender a dar respuestas probables a partir de los textos previamente vistos y que suenen aceptables, independientemente de que se correspondan con la realidad o no. Cuando un modelo de lenguaje da una respuesta inventada, decimos que alucina. En realidad, alucinar es precisamente para lo que están diseñados estos sistemas. Siempre alucinan, siempre inventan. Lo que pasa es que cuando hay una intersección entre la alucinación y la realidad lo llamamos acertar. Pero concatenar palabras optimizando una probabilidad (al margen de que el contenido se corresponda o no con la realidad) es la esencia del funcionamiento de estos bichos.

La irrupción de estos modelos hace justo ahora dos años ha producido una perturbación más que palpable en el paisaje textual cibernético. El texto humano (que construía la web y que hacía de internet el mayor acervo textual jamás creado) convive ahora con una cantidad creciente de texto artificial generado por las máquinas de verborrea sintética. La sombra de la duda se cierne inevitablemente cuando leemos hoy un texto: esto que estoy leyendo, ¿lo ha escrito alguien realmente?

Esa sospecha no es puramente filosófica, tiene derivadas concretas. Por ejemplo, en nuestra capacidad para estudiar cómo funcionan las lenguas. Durante años, la abundancia de textos en internet sirvió, entre otras cosas, para atestiguar cómo se expresan los hablantes de forma natural y espontánea en sus comunicaciones, lo que alimentó ingentes cantidades de investigaciones lingüísticas. Pero con el surgimiento de los textos producidos por la llamada inteligencia artificial generativa, internet se ha contaminado. Paradójicamente, la sobreabundancia de texto sintético que llena hoy internet ha producido un apagón textual sin precedentes. El texto humano sigue ahí, pero no tenemos forma de distinguirlo del artificial, invalidando todas nuestras observaciones sobre el idioma (y disparando nuestra suspicacia como lectores).

Un caso reciente es el del proyecto wordfreq, que recopilaba la frecuencia de las palabras a partir de los datos de uso de distintas fuentes, como las redes sociales, Wikipedia o los subtítulos audiovisuales. Uno podía consultar, pongamos, cuánto de frecuente es la palabra “café” en castellano, en francés o en inglés. Pero la desarrolladora del proyecto, Robyn Speer, decidió poner fin a las actualizaciones de wordfreq hace unas semanas. En su despedida del proyecto, Speer constataba un hecho inquietante: desde 2022 en adelante ya no es posible disponer de información fiable sobre cómo los humanos usan la lengua. De la misma manera que las detonaciones atómicas a partir de los años cuarenta produjeron un fino manto de polvo radiactivo que se depositó sobre la superficie de la Tierra dejando una impronta detectable en la composición de nuestro planeta, la explosión de texto sintético producido por la IA generativa ha modificado irreversiblemente el entorno lingüístico que habitamos. El mundo textual tal y como lo conocíamos ya no existe.

La consecuencia de todo esto trasciende lo puramente lingüístico y plantea algunas cuestiones interesantes sobre el futuro de la IA textual. Los grandes modelos de lenguaje de la primera hornada tuvieron ocasión de aprender de todo el internet anterior a 2022, el internet genuinamente humano, el que escribieron fundamentalmente personas. Los modelos siguientes entrenados con textos posteriores a 2022 están tragándose inevitablemente esos textos que han escrito otras máquinas y que hoy copan internet. Es decir, esos futuros grandes modelos que deberían superar a los de la generación anterior muy probablemente tendrán que aprender de unos textos que, en gran proporción, ya no serán humanos, comprometiendo su calidad. Es lo que algunos llaman “inteligencia artificial Habsburgo”: el entrenamiento endogámico de una máquina de texto sintético a partir de otros textos también sintéticos produce monstruos.

Con un internet anegado de pseudotextos sintéticos, unos buscadores reconvertidos en catálogos publicitarios y unos sistemas de respuesta automática creados para ser más complacientes que factuales, el futuro del acceso al conocimiento parece incierto. ¿Dónde vivirá la información atesorada por la humanidad con tanto esfuerzo el día de mañana? ¿Cómo podremos consultarla? Tendemos a pensar en las búsquedas en internet y en los sistemas de acceso a la información como desafíos eminentemente tecnológicos, pero estas son también cuestiones filológicas de primer orden. La biblioteca que antaño albergó todo el conocimiento humano está hoy en llamas. Y los sabios que podrían darnos las respuestas se están haciendo esperar.